Почему вы думаете, что за ис ... Бесплатный веб-парсер 2023: 10 лучших бесплатных инструментов и программ для веб-парсинга

Бесплатный веб-парсер 2023: 10 лучших бесплатных инструментов и программ для веб-парсинга...

Почему вы думаете, что за использование веб-парсеров нужно платить, на самом деле существуют бесплатные веб-парсеры, которые предоставляют вам основные возможности веб-парсинга бесплатно. В статье ниже мы рассмотрим некоторые из лучших бесплатных веб-парсеров на рынке.

Обзор лучших бесплатных веб-парсеров на рынке

- ParseHub: Бесплатный с ограничениями — <Mac, Windows и Linux> — Лучший бесплатный веб-парсер.

- Octoparse: Бесплатно с ограничениями — <Mac и Windows> — Расширенный веб-парсер

- io Extension: Совершенно бесплатно — <Расширение Chrome> — Лучшее бесплатное расширение Chrome для веб-парсинга

- Scraper: Полностью бесплатно — <Chrome Extension> — Лучший для промежуточных и продвинутых пользователей XPATH

- Apify: Некоторые актеры бесплатны с ограничениями — <NodeJS и Python> — Лучшее для кодеров

Топ-10 инструментов и программного обеспечения для веб-парсинга в 2022 году

Как вы думаете, зачем вам нужен веб-парсер? Если вы можете скопировать и вставить информацию на веб-страницу вручную, то зачем вам инструмент для веб-парсинга? В случаях, когда количество информации невелико и может быть собрано на одной веб-странице, то копирования и вставки будет достаточно. А как быть в случае, когда вам нужны большие объемы данных со многих веб-страниц со сложной структурой? Вы все еще копируете и вставляете? Это может быть громоздко и утомительно. Конечно, вы подумаете о том, как собрать эти данные за короткое время. Отсюда возникает необходимость в веб-парсере. Боты для веб-парсинга используют методы автоматизации для извлечения данных с веб-страниц в кратчайшие сроки. Лучшие веб-парсеры на рынке — это платные веб-парсеры. Однако это не означает, что вы не можете получить веб-парсеры для бесплатного использования. На самом деле, есть некоторые веб-парсеры, которые полностью бесплатны, в то время как другие являются платными веб-парсерами с бесплатными уровнями. Мы прочесали рынок в поисках работающих бесплатных веб-парсеров, и в этой статье мы откроем вам некоторые из лучших веб-парсеров на рынке, которые вы можете использовать для своих легких задач веб-парсинга без оплаты.

Parsehub — лучший бесплатный веб-парсер

- Ценообразование: Бесплатно с платным планом

- Бесплатные пробные версии: Бесплатно — дополнительные функции предоставляются за дополнительную плату

- Формат вывода данных: Excel, JSON,

- Поддерживаемые платформы: Облако, настольный компьютер

Parsehub — это бесплатный инструмент для сбора данных с веб-страниц. Он с легкостью извлекает данные с веб-страниц. Этот инструмент способен извлекать данные с веб-страниц, которые построены и закодированы на JavaScript, технологиях AJAX и даже cookies. Таким образом, это эффективный веб-парсер для парсинга данных со всех видов веб-сайтов, включая интерактивные веб-страницы. Это настольное приложение полезно для исследователей, маркетологов, научных работников и специалистов по мониторингу изменений. Это не зависит от их знаний в области кодирования или программирования. Это объясняется тем, что вам не придется писать ни строчки кода, поскольку программа предоставляет интерфейс «укажи и щелкни» для определения интересующих данных на странице. Parsehub совместим с такими устройствами, как Windows, Linux и macOS. Кроме того, вы можете воспользоваться расширением для браузера для немедленного сбора данных. Хотя инструмент позволяет установить только пять задач по сбору данных для бесплатных пользователей, это количество проектов может достигать 20, если вы решите заплатить за премиум-пакет, при этом вы по-прежнему будете наслаждаться большой анонимностью с помощью IP-прокси.

Data Scraper — бесплатный для легкого веб-парсинга

- Ценообразование: Бесплатно 500 страниц ежемесячно

- Бесплатные пробные версии: 500 страниц в месяц бесплатно

- Формат вывода данных: CSV, XSL

- Поддерживаемые платформы: Chrome

Этот веб-парсер представляет собой плагин, работающий в браузере Chrome. Он обеспечивает легкий парсинг страницы, содержащей табличный или списочный тип данных. Извлеченные данные будут отформатированы в файлы CSV или XSL. Бесплатный пакет этого инструмента представляет собой персонализированный браузер на chrome и позволяет извлекать данные о страницах до 500 в месяц. Этого будет достаточно для нетяжелого парсинга экрана с небольшим объемом данных. В дополнение к этим функциям платный тарифный план собирает больше страниц и даже предлагает услуги API и IP-прокси. Таким образом, можно не беспокоиться о сайтах с жесткими ограничениями для парсеров. Вы можете рассмотреть платную версию и изучить многие другие возможности.

Расширение WebScraper.io — лучший веб-парсер для Chrome

- Ценообразование: Freemium

- Бесплатные испытания: Freemium

- Формат вывода данных: CSV, XLSX и JSON

- Поддерживаемая платформа: Браузерное расширение (Chrome и Firefox)

WebScraper — это инструмент, имеющий расширение для хрома для мгновенного парсинга экрана. За годы его существования было зарегистрировано более 400 тысяч пользователей. Это один из визуальных веб-парсеров с интерфейсом «наведи и щелкни», что делает его удобным для использования не кодерами. Его хромированная версия очень гибкая, поскольку вы можете создать карту, по которой будет осуществляться путешествие по сайту. Проще говоря, вы можете создавать карты для навигации по сайту и маршрутов парсинга данных. Помимо расширения для браузера. Этот сервис предлагает услугу облачного парсинга. Это версия, с помощью которой можно собирать большое количество данных, а также выполнять несколько одновременных задач. И расширение Chrome, и облачный сервис способны извлекать данные со страниц с JavaScript или AJAX. Версия для браузера экспортирует данные в CSV, а облачная версия делает это в форматах CSV, XLSX и JSON. Все эти документы с данными могут быть доступны с помощью веб-крючков или API. Таким образом, вы можете экспортировать их через Dropbox, Google Sheets или Amazon S3. На сайте компании есть бесплатная пробная версия для изучения возможностей платного пакета.

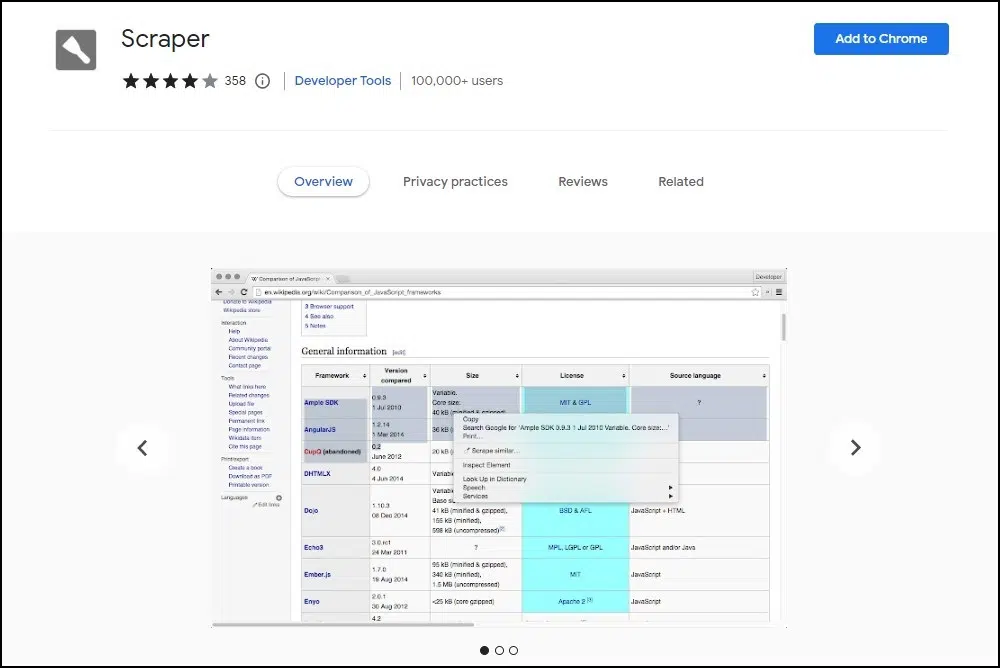

Scraper — бесплатный веб-парсер для пользователей XPATH

- Ценообразование: Бесплатно

- Бесплатные испытания: Бесплатно

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Chrome

Scraper — это простой в использовании инструмент для сбора данных на веб-страницах, предназначенный для средних и опытных пользователей с опытом работы с XPATH. Это расширение для браузера Chrome собирает данные с веб-страниц, которые не являются сложными по структуре. Оно делает это и представляет извлеченные данные в виде электронной таблицы для использования. Таким образом, оно облегчает ваши исследования в Интернете, поскольку вы можете быстро собирать данные. Этим инструментом могут пользоваться как новички, так и профессионалы. Лучше всего он работает при сборе данных, которые находятся в табличной форме на веб-страницах. Для этого просто щелкните правой кнопкой мыши после выбора набора данных, которые вы хотите извлечь. Затем нажмите «Scrape Similar» в меню браузера. Это так просто. С помощью Scraper вы можете копировать данные в буфер обмена и даже обновлять документы для мгновенного экспорта в Google Docs. Вы также можете добавить дополнительные столбцы с помощью JQuery или Xpath. Следует отметить, что воспользоваться этой функцией могут люди, предварительно владеющие XPath.

Octoparse

- Ценообразование: От 75 долларов в месяц

- Бесплатные пробные версии: 14 дней бесплатной пробной версии с ограничениями

- Формат вывода данных: CSV, Excel, JSON, MySQL, SQLServer

- Поддерживаемые платформы: Облако, настольный компьютер

Инструмент для парсинга Octoparse — это один из парсеров, который можно использовать как с навыками кодирования, так и без них. Проще говоря, его можно назвать парсером «наведи и щелкни». Он настолько эффективен для поиска данных и удобен не только для исследователей, но и для предпринимателей. Бесплатная версия парсера может служить вам достаточно долго, если вам нужны только основные данные с веб-страниц. Однако если вы хотите добывать большие объемы данных, вам, возможно, придется приобрести платную версию. Стоит отметить совместимость программы как с Windows, так и с Mac OS. Интересно, что на официальной странице есть демо-версия, демонстрирующая простоту использования. Более того, вам будет предоставлена двухнедельная бесплатная пробная версия. Это также можно увидеть на сайте. Octoparse отлично справляется со сбором данных на веб-страницах, построенных с использованием JavaScript, AJAX, cookies и т.п. Наконец, все собранные данные можно загрузить в желаемом формате, например, CSV, Excel или API.

Data Miner — лучшее бесплатное расширение веб-парсера для браузера Edge

Data Miner — это американский инструмент для веб-парсинга. Его бесплатная версия является расширением для браузеров Google Chrome и Edge. Этот инструмент способен просматривать не только отдельные страницы, но и веб-сайты с множеством страниц и собирать полезные данные в соответствии с вашими интересами. Таким образом, Data miner проникает на веб-страницы и накапливает данные для использования в загружаемых форматах, таких как CSV и таблицы Excel. Это облегчает составление заключений о вашем бизнесе с помощью инструментов анализа данных. Иногда мощный инструмент может показаться сложным в использовании, судя по его интерфейсу. С Data Miner дело обстоит иначе. Его пользовательский интерфейс легко понять, поскольку он требует меньше осознанности. На самом деле, достаточно одного клика, чтобы извлечь данные из массива правил анализа данных, которых насчитывается до 60 тысяч. Как будто этого недостаточно. Если у вас есть желаемый шаблон извлечения, вы также можете настроить правило для задачи добычи данных.

Scrapestack — бесплатный API для веб-парсинга

- Цены: От $20 в месяц

- Бесплатные испытания: 100 запросов в месяц бесплатно

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

Scrapestack — известный поставщик услуг API-парсеров и прокси. За годы работы они обслужили более 200 компаний. Они утверждают, что парсят веб-страницы за миллисекунды. Scrapestack предлагает бесплатный сервис API веб-парсинга. Этот инструмент предлагает вам решение проблем, связанных с добычей данных. Он обладает сложными функциями, которые решают проблему CAPTCHA, позволяют отправлять несколько API-запросов одновременно, а также работает с браузерами. Несмотря на то, что вы будете удовлетворены бесплатным планом, вы хотели бы увидеть больше возможностей, которые могут быть открыты в платном плане. Он стоит всего 19,99 долларов США в месяц. Этот инструмент имеет широкий спектр применения. Это эффективный сборщик данных для поисковых систем, таких как Google и Youtube. Кроме того, он также собирает данные для таких онлайн-рынков, как eBay и Amazon. Не исключены и социальные сети, такие как Instagram, Facebook и Twitter.

Apify — бесплатный веб-парсер для разработчиков

- Ценообразование: От $49 в месяц за 100 вычислительных единиц Actor.

- Бесплатные пробные версии: Стартовый план включает 10 вычислительных блоков Actor

- Формат вывода данных: JSON

- Поддерживаемые ОС: облачные — доступ через API

Apify — это готовый к использованию мощный инструмент для веб-парсинга и автоматизации. Он предлагает различные услуги, начиная от сбора данных, автоматизации и заканчивая услугами прокси. Следовательно, он хорош в том, что делает. Он предлагает группу ботов, известных как агенты, которые вы можете бесплатно использовать для сбора данных, причем наиболее популярным является общий агент для сбора данных. Помимо бесплатных веб-парсеров, эта служба также предоставляет вам бесплатные общие прокси. Однако следует знать, что Apify предназначен для кодеров, которые не хотят изобретать велосипед. Если вы не являетесь разработчиком nodeJS или Python, веб-парсеры Apify не для вас. С Apify у вас есть шанс свободно парсить неограниченное количество данных в структурированных форматах. Наборы данных, извлеченные Apify, автоматически форматируются в CSV или JSON. Таким образом, они становятся читаемыми для аналитических машин. Это активно подразумевает, что вы можете интегрировать набор данных в существующий рабочий процесс или создать новый с помощью API и Webhooks.

ProxyCrawl — бесплатные специализированные веб-парсеры для конкретных веб-сайтов

- Цена: От $29 в месяц

- Бесплатные испытания: 100 кредитов API

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

ProxyCrawl — это инструмент для веб-парсинга, который работает как прокси-сервер. Он был создан с учетом технических требований, чтобы помочь владельцам бизнеса с легкостью собирать данные. Они могут добывать и извлекать данные с веб-страниц с высокой анонимностью. Он отлично работает как с большими, так и с малыми объемами данных. Proxy crawl имеет возможность собирать данные со всех типов веб-сайтов. Хотя для получения доступа к полному пакету услуг вам придется заплатить всего лишь символическую сумму, есть возможность создать бесплатный аккаунт и собирать данные точного качества и размера, но с определенными ограничениями. Кроме того, встроенная в него прокси-программа обходит ограничения веб-сайтов и преодолевает CAPTCHA. Она извлекает данные с крупных сайтов и поисковых систем, таких как Yahoo, Amazon, Yandex, Glassdoor, и даже с платформ социальных сетей, таких как Facebook, LinkedIn и им подобных. Интересно, что API делает скриншот сайта, который просматривается.

- Ценообразование: Индивидуальное предложение

- Бесплатные пробные версии: Доступен 30-дневный бесплатный ограниченный план

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

В мире, где многие владельцы бизнеса нанимают разработчиков и сборщиков данных, Mozenda сделает лучшую работу за более короткий срок и с более высокой точностью. С 2007 года Mozenda является одним из самых первых разработчиков технологии парсинга. За это время он просмотрел миллиарды веб-страниц. Многие клиенты полагаются на этот инструмент для ежедневного сбора данных. Это просто потому, что он помогает парсить данные, которые представляют собой не только текст, но и изображения, файлы и даже PDF-контент на веб-сайтах. После этого данные будут оформлены в формате, подходящем для публикации. Таким образом, API можно использовать для экспорта собранных данных в CSV, JSON, TSV или XML. Кроме того, Mozenda дает вам возможность интегрировать данные с выбранных вами партнерских платформ. Вы получите 30 дней бесплатного использования Mozenda. Эти 30 дней предназначены для того, чтобы показать вам, на что способен этот инструмент. Попробуйте, и вы будете убеждены в необходимости приобретения платных услуг.

Часто задаваемые вопросы

Что такое бесплатные веб-парсеры? Веб-парсеры — это, по сути, автоматизированные боты, предназначенные для извлечения общедоступных данных из Интернета. Обычно эти веб-парсеры имеют свою цену. Веб-парсеры, за использование которых вам не нужно платить, можно назвать бесплатными веб-парсерами. Возможно, вам будет интересно узнать, что бесплатность не означает, что вы не будете тратить деньги на их использование. Большинство из них требуют прокси для работы, и вам нужно купить вращающиеся прокси для веб-парсинга, так как бесплатные не являются надежными или даже пригодными для использования. Большинство бесплатных веб-парсеров не являются полностью бесплатными, так как существуют ограничения, согласно которым только платные пользователи получают все возможности.

Является ли веб-парсинг законным? В прошлом веб-парсинг находился в серой зоне, и некоторые спорили о том, является ли это законной деятельностью или нет. Теперь это не так, поскольку существуют судебные запреты, которые сделали его законным. Вы можете парсить общедоступные данные с помощью веб-парсинга при условии, что вы не нанесете вреда целевому веб-серверу. Важно знать, что это не юридическая консультация, за которой лучше обратиться к компетентному юристу. Также важно знать, что региональные законы могут отличаться, но в целом веб-парсинг считается законным.

Зачем использовать бесплатные веб-парсеры? Веб-парсеры стоят денег и времени на разработку, обслуживание и управление. По этим причинам веб-парсеры должны иметь свою цену. Именно поэтому бесплатные веб-парсеры имеют некоторые ограничения. Однако не всегда вам нужны все возможности веб-парсера или даже расширенные возможности веб-парсеров. Если вы легкий пользователь, которому нужно парсить всего несколько страниц с сайта, вы можете воспользоваться бесплатными веб-парсерами и использовать деньги для других аспектов вашего бизнеса.

Хороши ли бесплатные веб-парсеры? Платные веб-парсеры являются лучшими, поскольку при их использовании вы получаете максимум возможностей и преимуществ. Однако бесплатные веб-парсеры не так уж плохи, поскольку их тоже можно использовать для сбора данных. Некоторые из бесплатных веб-парсеров, включая WebScraper.io Extension, вполне удобны в использовании и предлагают вам множество дополнительных функций бесплатно. Возможно, им не хватает некоторых премиум-функций платных веб-парсеров, но они также хороши для веб-парсинга, и если вам нужно просто парсить данные из Интернета без дополнительных функций, то они вполне подойдут для этого.

Заключение

В итоге, появление технологии веб-парсинга — это большая победа в извлечении и анализе данных. Это, несомненно, облегчает задачу в развитии технологии. Если данные по-прежнему будут собираться и упорядочиваться вручную путем копирования и вставки, то сравнение и актуальные выводы о рыночных ценах, колебаниях в бизнесе, изменениях в окружающей среде и даже научных исследованиях всегда будут оставаться утомительной задачей. Таким образом, использование таких технологий, несомненно, является обязательным для всех, кто хочет принимать обоснованные решения в кратчайшие сроки. К счастью, многие из них бесплатны, а некоторые имеют бесплатный период использования. Вы можете взять любой из перечисленных выше веб-парсеров и с легкостью извлечь данные.