Если вы еще не используете ? ... Что такое веб-парсинг и как его делать

Что такое веб-парсинг и как его делать...

Если вы еще не используете веб-парсинг в своем арсенале, вы определенно упускаете огромную возможность получить преимущество над конкурентами. Если вы похожи на большинство продавцов, вы всегда ищете преимущество перед конкурентами. Вы хотите найти новых потенциальных клиентов, укрепить отношения с текущими клиентами и лучше понять свою отрасль в целом. Веб-парсинг может помочь вам сделать все это и даже больше. Подумайте о тех случаях, когда вам хотелось получить список всех компаний вашей отрасли, расположенных в определенном городе. Или, может быть, вы хотели бы получить список всех контактов в определенной компании. Веб-парсинг может помочь вам получить эту информацию быстро и легко. Но что это такое и как это работает? В этой статье блога мы ответим на эти и другие вопросы. Продолжайте читать, чтобы узнать все, что вам нужно знать об этом мощном инструменте!

Что такое веб-парсинг?

Представьте, что вам приходится смотреть на что-то подобное целый день. Весело, правда…? А теперь представьте, что есть способ отсортировать все эти данные за считанные секунды и получить упорядоченный набор. По сути, это и есть парсинг данных. Вкратце, веб-парсинг — это способ извлечения данных с веб-сайтов. Обычно это делается автоматически с помощью компьютеров, но может быть сделано и вручную. Существует несколько различных способов, но основная идея заключается в том, чтобы загрузить веб-страницу и затем проанализировать HTML-код, чтобы найти нужные данные. Найдя нужные данные, вы можете сохранить их в файл или базу данных для последующего использования. Веб-парсинг может быть полезен для решения самых разных задач, например, для получения списка всех названий товаров и цен в интернет-магазине или извлечения данных с веб-форума, чтобы узнать, что люди говорят на определенную тему.

Является ли веб-парсинг бесплатным?

Большинство инструментов для веб-парсинга бесплатны, хотя есть и платные варианты. Платные варианты обычно предлагают больше функций и более просты в использовании, но бесплатные варианты, как правило, отлично справляются со своей задачей. Законен ли веб-парсинг? Это наиболее часто задаваемый вопрос, и ответ на него… зависит от ситуации. В целом, парсить общедоступные данные с веб-сайтов вполне нормально. Однако если вы собираете данные, которые должны быть приватными (например, чью-то контактную информацию), то у вас могут возникнуть проблемы с законом. Это распространенный вопрос, и ответ на него… зависит от ситуации. В целом, парсить открытые данные с веб-сайтов совершенно нормально. Однако если вы собираете данные, которые должны быть приватными (например, чью-то контактную информацию), то у вас могут возникнуть проблемы с законом.

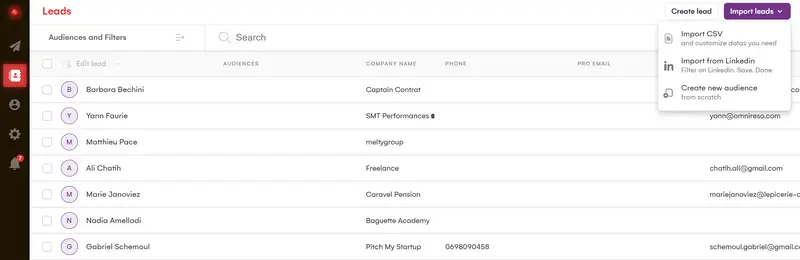

Всегда полезно ознакомиться с условиями предоставления услуг на сайте, с которого вы собираетесь считывать данные, чтобы убедиться, что вы не нарушаете никаких правил. В LaGrowthMachine мы разработали собственные методы сбора данных, используя несколько источников данных и различные технологии, что позволяет нам иметь одну из лучших функций обогащения данных на рынке. Мы восстанавливаем до 28 различных элементов данных по нашим ссылкам (всегда следуя RGPD-дружественному подходу), что позволит вам автоматизировать работу в соответствии с очень точными переменными и быть очень естественными в своем подходе. Хотя эта практика появилась не так давно, она имеет тенденцию становиться все более распространенной и обширной. Она стала незаменимой для маркетологов роста и малого и среднего бизнеса, которые хотят сочетать эффективность и реактивность. Итак, это то, из-за чего поднялась шумиха, но как веб-парсинг на самом деле приносит пользу вашему бизнесу?

Зачем вам нужен веб-парсинг?

Самое очевидное преимущество веб-парсинга заключается в том, что он может сэкономить вам много времени. Представьте, если бы вам приходилось вручную копировать и вставлять данные с сайтов каждый раз, когда вы хотите провести маркетинговое исследование. Это заняло бы целую вечность! Но с помощью веб-парсинга вы можете получить все необходимые данные всего за несколько минут. Еще одним большим преимуществом является то, что с его помощью можно получить данные, которые трудно или невозможно получить каким-либо другим способом. Например, если вы хотите изучить новый рынок, веб-парсинг поможет вам быстро и легко получить список всех компаний на этом рынке. Кроме того, веб-парсинг можно использовать для решения самых разных задач, среди которых наиболее распространенными являются следующие:

- Генерация лидов: Сокращение данных с веб-сайтов может стать отличным способом поиска новых потенциальных клиентов. Например, вы можете использовать данные из каталога предприятий, чтобы найти все компании вашей отрасли, расположенные в определенном городе.

- Исследование рынка: Веб-парсинг можно использовать для сбора данных об определенной отрасли или рынке. Затем эти данные могут быть проанализированы, чтобы помочь вам лучше понять рынок в целом.

- Анализ конкурентов: Следить за конкурентами важно в любом бизнесе. Сокращая данные с их сайтов, вы сможете лучше понять их продукцию, ценообразование и маркетинговые стратегии.

Если пойти еще дальше, то с помощью полученных данных можно настроить многоканальные кампании в LaGrowthMachine. Как вы можете видеть, этот метод очень успешен, с почти 60-процентным процентом ответов! Теперь, когда мы познакомили вас с веб-парсингом и показали некоторые его преимущества, давайте рассмотрим основы его работы.

Как работает веб-парсинг?

Веб-парсинг обычно выполняется автоматически с помощью компьютеров, но может быть выполнен и вручную. Существует несколько различных способов, но основная идея заключается в загрузке веб-страницы и последующем разборе HTML-кода для поиска нужных данных. После того как вы нашли нужные данные, вы можете извлечь их в файл или базу данных для дальнейшего использования. Например, допустим, вы хотите извлечь данные из интернет-магазина, чтобы получить список всех названий товаров и цен. Сначала вам нужно будет найти и загрузить веб-страницу, которую вы хотите парсить. Затем нужно написать код, который будет анализировать HTML-код веб-страницы и извлекать интересующие вас данные. И наконец, нужно сохранить данные в файл или базу данных. Веб-парсинг может быть выполнен на различных языках программирования, но наиболее популярными являются Python, Java и PHP. Если вы только начинаете заниматься веб-парсингом, мы рекомендуем использовать такие инструменты, как ParseHub или Scrapy. Эти инструменты позволяют легко парсить данные с веб-сайтов без необходимости написания кода.

Каковы некоторые лучшие практики веб-парсинга?

Теперь, когда вы знаете основы веб-парсинга, давайте рассмотрим некоторые лучшие практики, о которых следует помнить.

Проверьте условия предоставления услуг

Как мы уже говорили, вам необходимо ознакомиться с условиями предоставления услуг на сайте, с которого вы собираетесь делать копирование. Это позволит убедиться, что вы не нарушаете никаких правил и избежать возможных неприятностей — юридических или иных — в дальнейшем. Неплохо также получить разрешение от владельца сайта, прежде чем приступать к парсингу, поскольку некоторые веб-мастера могут быть не в восторге от этого.

Используйте правильные инструменты

Существует множество различных инструментов для веб-парсинга, поэтому важно выбрать подходящий для ваших нужд. Кстати говоря, LaGrowthMachine — один из них! Мы рассмотрим список лучших инструментов для веб-парсинга далее в этом руководстве, но пока мы просто упомянем несколько самых популярных из них:

- Scrapy: Scrapy — это фреймворк для веб-парсинга, написанный на языке Python. Это один из самых популярных инструментов, который используют такие крупные компании, как Google, Yahoo и Facebook.

- ParseHub: ParseHub — это веб-парсер, который поддерживает широкий спектр языков и веб-платформ.

- Octoparse: Octoparse — это еще один веб-парсер, который поддерживает как статические, так и динамические веб-страницы.

Не перегружайте серверы

Когда вы парсите данные с веб-сайтов, важно не перегружать их серверы слишком большим количеством запросов. Это может привести к тому, что ваш IP-адрес будет заблокирован на сайте. Чтобы избежать этого, делайте запросы с интервалом и не делайте слишком много запросов одновременно.

Обрабатывайте ошибки

Неизбежно, что в какой-то момент вы столкнетесь с ошибками. Будь то неработающий сайт или данные не в том формате, который вы ожидали, важно запастись терпением и аккуратно обращаться с ошибками. Вы же не хотите рисковать сломать что-то из-за того, что слишком торопитесь.

Регулярно просматривайте свои данные

Важно регулярно пересматривать свои данные. Иногда веб-страницы меняются, и извлекаемые вами данные могут перестать быть точными. Регулярный пересмотр данных поможет вам всегда получать точную информацию.

Парсите ответственно

Важно уважительно относиться к веб-сайтам, с которых вы собираете данные. Это означает, что не следует собирать слишком много данных, не следует собирать их слишком часто и не следует собирать конфиденциальные данные. Кроме того, убедитесь, что ваш парсер обновляется, чтобы случайно не сломать сайт, который вы парсите.

Знайте, когда остановиться

Бывают случаи, когда вы не можете получить нужные вам данные с веб-сайта. Когда это происходит, важно знать, когда остановиться и двигаться дальше. Не тратьте время на попытки заставить свой веб-парсер работать — есть и другие сайты с нужными вам данными. Это лишь некоторые из лучших практик, о которых следует помнить при выполнении извлечения данных. Соблюдение этих рекомендаций поможет обеспечить положительный опыт и избежать любых потенциальных проблем.

5 лучших инструментов для веб-парсинга

Как мы уже говорили, существует множество веб-парсеров — от сложных фреймворков до простых инструментов. В этом разделе мы рассмотрим несколько наиболее популярных инструментов для парсинга. Итак… мы уже упомянули основные инструменты, такие как Scrapy и ParseHub, поэтому мы просто быстро пройдемся по некоторым другим.

Python

Python — один из самых очевидных вариантов для решения задач веб-парсинга. Это универсальный язык сценариев, который можно использовать как для… сбора данных, так и для широкого круга других задач. Основное преимущество использования Python для веб-парсинга заключается в том, что его относительно легко изучить и использовать. Кроме того, Python имеет широкий спектр библиотек и модулей, которые могут быть использованы для извлечения веб-данных, что делает его необычайно мощным инструментом. Одним из недостатков является то, что веб-парсеры Python могут работать медленно, особенно если они пытаются парсить большой объем данных. Кроме того, некоторые веб-сайты могут блокировать доступ к нему, что означает, что зачастую извлечение данных из Интернета с помощью Python может быть более трудоемким и сложным, чем использование других инструментов для извлечения данных. В целом, извлечение данных из Интернета с помощью Python имеет как преимущества, так и недостатки, но он остается популярным выбором для многих людей, желающих получить данные из Интернета.

Import.io

Это инструмент извлечения веб-данных, который позволяет парсить данные с веб-сайтов без необходимости написания какого-либо кода. Это один из самых удобных в использовании инструментов для извлечения данных из веб-сайтов, а также бонус: он отлично подходит для начинающих! Он включает в себя такие замечательные функции, как:

- Удобный пользовательский интерфейс «наведи и щелкни»

- Возможность парсить данные из-за входа в систему

- Автоматическая ротация IP-адресов, чтобы избежать блокировки

Преимущество import.io в том, что он может собирать данные с нескольких страниц сайта. Это полезно, если вам нужно получить данные с большого сайта с большим количеством страниц. Однако это также означает, что он может быть медленным при парсинге данных с веб-сайтов, содержащих тонну страниц. Еще одним преимуществом import.io является то, что он может парсить данные с веб-сайтов, которые «трудно» парсить: это означает, что он может обойти некоторые защитные механизмы, которые веб-сайты используют для предотвращения парсинга. При этом существует риск, что инструмент может сломаться, когда веб-сайты изменят свои механизмы защиты. В целом, import.io — отличный инструмент для быстрого сбора данных из Интернета, но важно знать о его ограничениях.

Mozenda

Mozenda — еще один инструмент для веб-парсинга, не требующий кодирования. Он включает в себя такие функции, как рендеринг веб-страниц, поиск веб-страниц и извлечение данных. Это отличное решение, поскольку оно просто в использовании и может быть настроено для парсинга данных практически с любого сайта. Одним из главных преимуществ использования Mozenda является то, что он очень быстрый и эффективный. Он может обрабатывать большие объемы данных очень быстро и легко. Кроме того, он очень удобен в использовании. Пользовательский интерфейс интуитивно понятен и прост в использовании. Также имеется широкий спектр онлайн-ресурсов, которые помогут вам начать работу с веб-парсингом с помощью этого инструмента. Однако одним из главных недостатков является то, что он довольно дорогой. Если вы планируете заниматься веб-парсингом только для личного пользования, то Mozenda может оказаться не лучшим вариантом для вас. Кроме того, он не всегда работает идеально. Иногда сайты могут менять свою структуру или дизайн, что может вызвать проблемы с веб-парсингом.

Apify

Будучи платформой для веб-парсинга, Apify позволяет превращать веб-сайты в структурированные данные. Она предлагает широкий спектр функций, включая возможность парсить динамические веб-страницы, создавать API и просматривать целые веб-сайты. Хотя Apify является мощным инструментом, у него есть некоторые ограничения: Во-первых, он не является бесплатным, поэтому, если у вас мало денег, он может оказаться не самым лучшим вариантом для вас. Кроме того, он может быть сложным в настройке и использовании, особенно для пользователей, не знакомых с веб-парсингом. Как бы то ни было, это один из самых масштабируемых веб-парсеров, которые вы можете использовать. Платформа может обрабатывать крупномасштабные данные, что делает ее идеальной для предприятий, которым необходимо собирать данные в больших масштабах. Тем не менее, эта масштабируемость имеет и обратную сторону: поскольку Apify может обрабатывать такие большие объемы данных, он может быть более подвержен ошибкам, и некоторые данные могут быть потеряны в процессе сбора. В целом, Apify остается популярной платформой для веб-парсинга благодаря своей гибкости и широкому набору функций. Если вы ищете простую в использовании платформу для веб-парсинга с широким набором функций, Apify может стать для вас хорошим вариантом.

DiffBot

Diffbot — это программное обеспечение для веб-парсинга, которое использует искусственный интеллект для извлечения данных с веб-страниц. Она предлагает широкий спектр функций, включая возможность широкомасштабного веб-парсинг, переползания веб-сайтов и извлечения данных из веб-страниц JavaScript. Основное преимущество использования Diffbot заключается в том, что он очень точен. Инструмент способен извлекать конкретные данные с высокой степенью точности, что означает, что вы с меньшей вероятностью столкнетесь с ошибками при его использовании. Он также способен извлекать данные с нескольких страниц и обрабатывать запросы AJAX, что всегда является плюсом. Более того, он очень удобен в использовании. Пользовательский интерфейс интуитивно понятен и прост в использовании, а также имеется широкий спектр онлайн-ресурсов, которые помогут вам начать работу с веб-парсингом с помощью Diffbot. Однако одним из самых больших недостатков Diffbot является его дороговизна, а также неспособность парсить данные с сайтов, использующих JavaScript для загрузки контента. Более того, для его полноценной работы необходимо, чтобы сайт был хорошо структурирован. В противном случае процесс парсинга данных может быть довольно медленным.

Наслаждайтесь поиском информации в Интернете… с осторожностью!

Веб-парсинг может быть отличным способом сбора данных из Интернета. Это быстрый, эффективный и относительно простой способ. Однако прежде чем приступать к веб-парсингу, необходимо знать о некоторых вещах. Во-первых, в некоторых случаях веб-парсингу может быть незаконным. Если вы планируете заниматься веб-парсингом в коммерческих целях, вам необходимо убедиться, что вы имеете на это законное право. Во-вторых, веб-парсинг может быть сложным. Хотя существует множество инструментов для веб-парсинга, которые довольно удобны в использовании и не требуют кодирования, некоторые сайты могут быть сложнее других. Наконец, веб-парсинг может отнимать много времени. Если вы планируете провести веб-парсинг большого сайта, вам может потребоваться некоторое время, чтобы получить все необходимые данные. Тем не менее, веб-парсинг может быть отличным способом быстрого и эффективного сбора данных. Просто убедитесь, что вы знаете о рисках, связанных с этим, прежде чем приступать к веб-парсингу. Удачного парсинга!