Выбор лучшего веб-парсера ?? ... 11 лучших облачных инструментов и сервисов для веб-парсинга в 2023 году

11 лучших облачных инструментов и сервисов для веб-парсинга в 2023 году...

Выбор лучшего веб-парсера — дело непростое. К счастью, мы подготовили для вас лучшие облачные инструменты для веб-парсинга, представленные на рынке. Предприятиям для работы необходимы данные, и хотя большинство данных отображается на веб-сайтах, они доступны только для просмотра. Это происходит потому, что пользователи не могут сохранять данные для личных целей. По этой причине пользователи выбирают процесс извлечения данных, который может быть чрезвычайно сложным. Однако инструмент веб-парсинга или облачный веб-парсер может облегчить эту работу. Инструмент веб-парсинга может получить данные в пригодной для использования форме, получить источник страницы, выполнить JavaScript и разобрать источники. Проще говоря, эти инструменты веб-парсинга могут автоматизировать процесс извлечения данных. Однако важно выбрать правильные инструменты веб-парсинга, чтобы получить доступ к точным, оперативным и надежным данным.

Лучшие инструменты и услуги облачного веб-парсинга в 2022 году

Scraper API

Scraper API — это лучший облачный веб-парсер, который специально разработан для дизайнеров и разработчиков веб-сайтов. Он может работать с CAPTCHA, прокси-серверами и несколькими веб-браузерами. Это означает, что необработанные HTML-данные с веб-сайтов могут быть извлечены с помощью одного вызова API. Он надежно работает с JavaScript и довольно удобен для интеграции с различными приложениями. Он интегрирован с геолоцированными вращающимися прокси, что означает, что каждый раз, когда вы делаете запрос, назначается новый IP-адрес, что делает невозможным вашу поимку. Существуют специальные пулы прокси-серверов, доступные для парсинга цен в электронной коммерции, парсинга социальных сетей и парсинга поисковых систем. Однако этот инструмент не является практичным решением для браузинга. Самое лучшее в Scraper API — это то, что он может восстанавливать неудачные запросы. У него удобный интерфейс, что делает его удобным в использовании и настройке. Пользователи могут использовать JavaScript для настройки типа запроса, заголовков и IP-геолокации.

Bright Data

Bright Data — это премиальный облачный инструмент веб-парсинга, используемый для извлечения данных. Он работает как сборщик данных, который обеспечивает индивидуальный и автоматизированный поток данных. Он интегрирован с функцией разблокировки данных, которая помогает получить доступ к скрытым данным, обещая доставку широкого спектра информации. Кроме того, он имеет систему управления прокси без кода и с открытым исходным кодом, что означает, что новички могут использовать его для извлечения данных без какого-либо кодирования. Bright Data разработан с поисковым краулером, поэтому пользователи могут получать информацию как из поисковых систем, так и с веб-сайтов. Самое лучшее в этом инструменте веб-парсинга то, что он доступен как расширение для браузера, поэтому процесс извлечения данных автоматизирован.

Существуют различные платные тарифные планы с разными возможностями, поэтому вы должны проанализировать разные тарифные планы, чтобы найти тот, который соответствует вашим личным предпочтениям. Существует две функции облачного парсинга. Во-первых, это веб-разблокировщик, который представляет собой автоматизированный инструмент для разблокировки веб-сайтов, который достигает целевых веб-сайтов и предоставляет точные данные. Он обладает мощной технологией разблокировки, которая помогает преодолевать блокировки и пароли. Более того, он предлагает IP-прайминг, управление файлами cookie и функцию автоматического выбора IP. Во-вторых, есть сборщик данных, с помощью которого пользователи могут выбрать формат для извлечения точных данных с веб-сайтов. Он может быть интегрирован с Google Cloud Storage, электронной почтой, Amazon S3 Bucket, Azure Cloud, API и webhooks для обеспечения автоматизированной доставки данных. И наконец, он имеет усовершенствованный алгоритм, который извлекает отраслевую информацию для предоставления структурированных и обработанных данных.

Apify

Apify — это веб-парсинг бот, который имеет облачные и автоматизированные функции для разработки API для веб-сайтов. Он интегрирован с центрами обработки данных и жилыми прокси-серверами, которые помогают в извлечении данных. Apify Store интегрирован с заранее разработанными инструментами парсинга для каждого популярного сайта, включая Google Maps, Instagram, Twitter и Facebook. С его помощью можно загружать данные в различных форматах, таких как Excel, HTML, JSON, CSV и XML. Он имеет прокси-сервер, который обеспечивает интеллектуальную ротацию IP-адресов, геолокационное таргетирование и извлечение данных HTTPS. Он имеет различные модули, которые включают функции обработки данных. Apify преобразует веб-страницы в API для улучшения извлечения и преобразования данных. Он оснащен краулером, обеспечивающим глубокий анализ веб-сайтов для извлечения данных. После извлечения данных в формате HTML они могут быть преобразованы в PDF. Программа также может просматривать различные страницы Google, включая Google Search и Google Places. Имеется функция мониторинга повреждений, которая помогает проверить содержимое веб-страницы и проанализировать ее SEO. Более того, он может проверять наличие неработающих ссылок на сайте.

ScrapingBee

ScrapingBee — это еще один инструмент для веб-парсинга, довольно популярный. Он может использоваться для рендеринга веб-страницы, как если бы это был настоящий интернет-браузер. Это означает, что он может управлять сотнями и тысячами безголовых данных с помощью недавно запущенной версии Chrome. ScrapingBee обещает надежную функциональность без замедления работы оперативной памяти и процессора. В нем доступен JavaScript-рендеринг, который отображает информацию в браузере и доставляет ее в HTML-файл. ScrapingBee имеет функцию вращающихся прокси, с помощью которой ваш IP-адрес вращается, чтобы владелец сайта не смог вас отследить. Он может выполнять общие задачи, такие как мониторинг цен, парсинг недвижимости и извлечение отзывов. Этот инструмент веб-парсинга можно использовать и для сканирования страниц результатов поисковых систем. Кроме того, в нем есть функция взлома роста, помогающая извлекать контактную информацию, данные из социальных сетей и генерировать лиды.

OctoParse

Если вы все еще ищете инструмент для веб-парсинга, OctoParse является одним из лучших инструментов, и он предназначен для людей, которые хотят извлекать и парсить данные без какого-либо программирования и кодирования. Даже без программирования и кодирования у вас будет полный контроль над процессом извлечения и интуитивно понятный пользовательский интерфейс для удобной работы. У него есть парсер сайтов, а также хостинговое решение для тех, кто хочет использовать парсеры в облаке, что делает его отличным облачным веб-парсером. OctoParse имеет экран «наведи и щелкни», который позволяет пользователям парсить формы заполнения и формы входа. Кроме того, он может рендерить JavaScript и позволяет прокручивать неограниченное количество веб-сайтов и страниц. С другой стороны, если вы опасаетесь, что вас могут забанить, OctoP имеет функцию анонимного парсинга данных, что означает, что ваша личность не будет раскрыта. Единственным минусом использования OctoParse является то, что он автоматически отключается через четыре часа, а это значит, что вам придется начинать все сначала.

ParseHub

ParseHub — один из самых мощных инструментов веб-парсинга, который можно использовать для запуска функций веб-парсинга без какого-либо программирования и кодирования. Использовать ParseHub так же просто, как выбрать данные и скопировать их. Неважно, являетесь ли вы журналистом, специалистом по изучению данных или аналитиком; ParseHub подойдет всем, кто хочет извлечь данные. Этот инструмент очищает HTML и текст перед загрузкой файла в систему, обещая структурированный файл. Графический интерфейс довольно прост, что делает его удобным для новичков. Его можно использовать для автоматического сохранения данных на серверах после сбора данных. Он интегрирован с автоматической ротацией IP-адресов для маскировки вашей личности путем постоянной смены IP-адреса, что исключает вероятность того, что вас забанят на сайтах. Самое лучшее в ParseHub — это то, что он позволяет пользователям собирать данные за логическими стенами. Кроме того, его можно использовать для извлечения данных из карт и таблиц. ParseHub отлично работает с различными операционными системами, включая macOS, Windows OS и Linux. Однако он не подходит для крупномасштабных проектов, поскольку часто возникают проблемы с публикацией полных отсканированных данных.

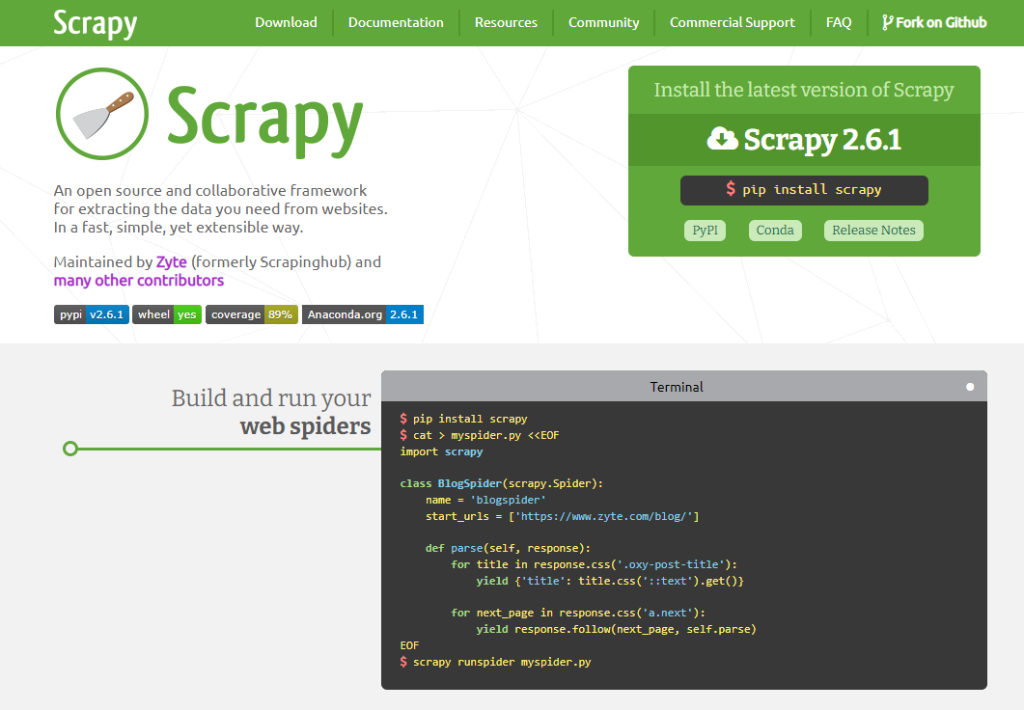

Scrapy

Scrapy — это известная библиотека веб-парсинга, которая широко используется разработчиками Python для создания высокомасштабируемых веб-парсеров. Она имеет полнофункциональную структуру, которая обрабатывает все основные функции, такие как запрос запросов и прокси-посредник. Это инструмент с открытым исходным кодом и может использоваться с облачными платформами, что делает его надежным облачным веб-пасером. Он поставляет хорошо документированные файлы, которые легко расширять, а развертывание довольно надежное и простое. Для Scrapy доступны модули промежуточного ПО, что делает его пригодным для интеграции инструментов. Однако для имитации запросов AJAX и PJAX требуется время, что делает весь процесс проверки данных утомительным.

Mozenda

Она ориентирована на крупные предприятия, особенно на те, которые ищут облачные платформы. На сегодняшний день ей удалось отсканировать более семи миллиардов страниц. Он предлагает интерфейс «наведи и щелкни», что означает, что вы можете выполнять функции веб-парсинга в кратчайшие сроки. Mozenda имеет функцию упорядочивания заданий и блокировки запросов, которая помогает собирать данные о веб-страницах. Более того, компания предлагает первоклассное управление учетными записями и поддержку клиентов для обработки ваших запросов. Она может собирать и публиковать данные в инструментах бизнес-аналитики и базах данных, чтобы убедиться, что данные правильно структурированы. Это масштабируемая платформа, что означает, что вы можете использовать ее по мере роста потребностей в сборе данных.

Webhose.io

Если вам нужен парсер данных и веб-парсинг для обмена контентом и маркетинговых целей, вы можете положиться на Webhose.io. Он обладает чрезвычайно надежным и эффективным индексированием контента, а служба поддержки готова оказать помощь в любое время. Его можно интегрировать с различными веб-сайтами для более удобного парсинга данных. API просты в использовании, обещают лучший контроль над выбором источника и языка. Кроме того, пользовательский интерфейс довольно интуитивно понятен, что делает его простым в использовании, даже если кто-то является новичком. Он предоставляет информацию и данные в форматах XML и JSON, что означает, что они машиночитаемы и правильно структурированы. Кроме того, он позволяет пользователям получить доступ к историческим данным, начиная с десятилетнего периода. Кроме того, он предоставляет доступ к хранилищу данных без дополнительной платы. И последнее, но не менее важное: она помогает реализовать гранулярный анализ данных, что позволяет глубже изучить их. Единственное, что вам нужно помнить, — это то, что настройка не очень удобна для тех, кто не является разработчиком.

Common Crawl

Common Crawl предназначен для всех, кто хочет исследовать данные и анализировать их для получения глубоких деталей. Он предоставляет открытые наборы исходных и извлеченных данных. Одной из лучших особенностей Common Crawl является то, что он предоставляет множество ресурсов для учителей и преподавателей, которые хотят проводить анализ данных. Однако он не предоставляет структурированных данных, что означает, что вам придется самостоятельно анализировать данные и организовывать их.

Dexi.io

Dexi.io остается одним из самых надежных веб-парсеров, доступных на рынке, и имеет облачную функциональность. К нему можно легко получить доступ через веб-браузер, что означает отсутствие необходимости в загрузке отдельного приложения. Он поддерживает все веб-сайты и интегрирован с системой дедупликации, которая удаляет дублирующуюся информацию из наборов данных. Кроме того, он разработан с различными дополнениями, так что вы можете расширить функциональность этого инструмента парсинга.

Что такое парсинг сайтов?

Веб-парсинг или парсинг веб-сайтов — это процесс, автоматизирующий сбор структурированных данных с различных веб-сайтов в Интернете. Он также известен как извлечение данных. Компании могут использовать методы веб-парсинга в качестве метода мониторинга конкурентов, так как это помогает в исследовании рынка, мониторинге цен, генерации лидов, мониторинге новостей и ценовой разведке. Однако важно добавить, что веб-парсинг связан только с легальным приобретением общедоступных данных, имеющихся в Интернете. Он не включает в себя продажу частной информации предприятий и частных лиц. В большинстве случаев компании используют веб-парсинг для принятия обоснованных бизнес-решений. Он позволяет получить разнообразную информацию за один запрос, на что уходят дни и недели при использовании ручных процессов.

Почему важно парсить веб-данные?

Частные лица и компании стремятся извлекать данные с помощью автоматизации по разным причинам. Прежде всего, это ускоряет процесс сбора и парсинга данных, что повышает общую производительность. Такое быстрое получение информации также помогает компаниям узнать о тенденциях рынка. Во-вторых, спарсенные данные можно использовать для получения информации о ценах на продукты и услуги, установленных конкурентами. Это поможет предприятиям электронной коммерции и другим компаниям обновлять свои веб-сайты в социальных сетях, чтобы делиться информацией о ценах. Кроме того, бренды могут делиться скидками и купонами, чтобы привлечь клиентов. В-третьих, веб-парсинг может помочь в отслеживании тенденций. Неважно, хотите ли вы укрепить свой бизнес или запустить новый, понимание предпочтений клиентов имеет большое значение. Веб-парсинг позволяет компаниям отслеживать последние тенденции рынка и создавать конкурентоспособные кампании и лучшие продукты, которые соответствуют предпочтениям клиентов. И последнее, но не менее важное: автоматизированные инструменты веб-парсинга автоматизируют процесс парсинга, что обеспечивает более высокий уровень точности собранных данных. Проще говоря, это устраняет вероятность ошибок, которые могли бы возникнуть, если бы данные собирал человек. С помощью таких точных данных компании могут адаптировать свои услуги, продукты, социальные сети и официальные веб-сайты для повышения стандартов удовлетворенности клиентов.

Особенности, которые необходимо учитывать при выборе инструментов для веб-парсинга

Существует неограниченный выбор инструментов для парсинга данных с различными функциями и стилями. Инструменты веб-парсинга должны удовлетворять потребности пользователей в извлечении данных с помощью удобного и интерактивного интерфейса. По этой причине необходимо учитывать некоторые другие факторы.

Простота в использовании

Большинство инструментов для веб-парсинга и извлечения данных поставляются с учебником, чтобы упростить их использование для клиентов, но у всех разные потребности в парсинге. Аналогично, некоторым пользователям требуется инструмент для парсинга, работающий на Windows, а некоторым — инструмент для парсинга, который хорошо работает на macOS. Поэтому неважно, какой инструмент для парсинга вам нужен; он должен иметь интуитивно понятный и удобный для новичков интерфейс.

Ценообразование

Обычно пользователи ищут инструмент для парсинга данных по доступной цене. Некоторые парсеры имеют бесплатные планы, но они обладают ограниченной функциональностью, в то время как платные планы лучше работают в плане мониторинга и управления методом извлечения данных. Кроме того, платные планы предлагают более глубокое извлечение данных по сравнению с бесплатными планами. Поэтому лучше выбрать платный инструмент с бесплатным пробным периодом, чтобы получить представление о его возможностях.

Форматы данных

Большинство инструментов для поиска информации в Интернете работают с популярными форматами данных, такими как CSV и JSON. Следует помнить, что каждый инструмент должен поддерживать эти два формата данных. CSV-файл — это файл Microsoft Excel, в то время как JSON проще для компьютерных устройств и легче для интерпретации пользователями. С другой стороны, если вам требуется расширенное извлечение данных, ваш инструмент должен иметь поддержку SSQL и XML.

Скорость и производительность

Надежный инструмент для парсинга должен иметь возможность установить API с любым сайтом в Интернете и работать через прокси. Лучше всего выбирать инструмент, который работает как приложение, а также как расширение, поскольку они лучше справляются с ротацией прокси. Кроме того, краулер с открытым исходным кодом поможет настроить задачи парсинга, обещая пользователям большую гибкость.

Поддержка клиентов

Неважно, какой инструмент для извлечения или парсинга веб-страниц вы выберете, важно проверить поддержку клиентов. Это связано с тем, что служба поддержки поможет вам получить помощь, если у вас возникнут проблемы с инструментом. В идеале поддержка клиентов должна быть доступна 224/7.

Итоги

Выбор инструмента для веб-парсинга и извлечения данных, который соответствует вашим потребностям, зависит от оценки ваших потребностей в данных и уровня квалификации, поскольку некоторые инструменты требуют от пользователей написания кодов. По этой причине вы всегда должны анализировать функции, предлагаемые различными инструментами веб-парсинга, чтобы выбрать тот, который работает в вашу пользу.